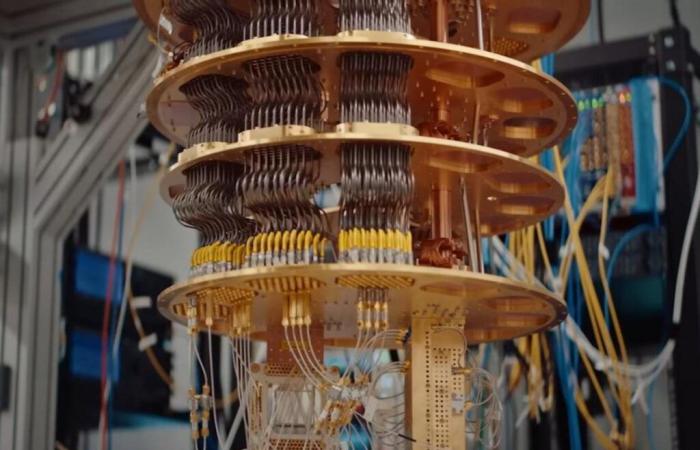

En début de semaine, Google a présenté Willow, la dernière version de son processeur quantique. Dans un article de blog, elle attribue à cette puce de 105 qbits des performances absolument époustouflantes ; en moins de 5 minutes, elle serait capable de résoudre des problèmes qui nécessiteraient 10 millions de milliards d’années de travail pour les meilleurs supercalculateurs actuels.

Mais il y a un hic : l’intérêt pratique des calculs en question est extrêmement limité, et il faudra encore attendre avant d’atteindre la « suprématie quantique » que Google a eu l’audace de revendiquer en 2019.

Le RCS, un benchmark pas forcément pertinent

Pour comprendre ce qui rend cette annonce discutable, il faut s’intéresser à la métrique utilisée par Google : random circuit sampling, ou RCS (pour Échantillonnage de circuits aléatoires). Ce test consiste à générer des séquences aléatoires de portes logiques quantiques qui seront écrites dans un ensemble de qbits – les unités logiques fondamentales de l’informatique quantique. En échantillonnant plusieurs fois ces circuits, le système produit alors des séries de bits dont la répartition statistique dépend de la configuration du circuit.

Il s’agit traditionnellement d’un exercice très exigeant pour l’informatique classique, car la complexité des calculs augmente de façon exponentielle avec le nombre de portes logiques. En d’autres termes, les supercalculateurs conventionnels deviennent rapidement obsolètes.

En revanche, ce problème est beaucoup plus abordable pour les ordinateurs quantiques. Les Qbits sont des entités quantiques qui peuvent exister dans une superposition d’états différents ; en d’autres termes, contrairement aux bits de l’informatique traditionnelle, ils ne sont pas limités à une seule valeur précise, comme 0 ou 1. Au lieu de cela, cette superposition quantique leur permet d’exister dans des états intermédiaires. Et surtout, dans des conditions idéales, tous ces qbits sont corrélés grâce à l’intrication quantique — le fameux « action effrayante à distance » mentionné par Einstein.

Cette combinaison de superposition et d’intrication est au cœur du fonctionnement d’un ordinateur quantique. Il permet à la machine de traiter différentes informations en parallèleet donc de résoudre des problèmes très complexes comme le RCS dans des délais extrêmement courts par rapport aux supercalculateurs traditionnels.

Abonnez-vous au Journal du Geek

Mais s’il s’agit effectivement d’un exercice très exigeant d’un point de vue strictement informatique, le RCS n’est pas forcément la référence la plus pertinente lorsqu’il s’agit de comparer les performances d’un ordinateur quantique. à ceux d’un supercalculateur conventionnel. En effet, à l’exception de quelques applications de niche dans des domaines comme le chiffrement, ce test n’a pas presque aucune utilité pratique dans le monde réel. Assez ennuyeux, si l’on considère que l’objectif principal des leaders de l’informatique quantique est de permettre à ces machines de résoudre des problèmes du monde réel.

Malgré les avantages pratiques limités de cette approche, Google continue d’affirmer que tous les ordinateurs quantiques doivent être jugés en fonction de leurs performances RCS. Pas étonnant, puisque la firme de Mountain View est désormais dominante dans ce domaine… et cela lui permet aussi deéviter les comparaisons directes avec ses principaux concurrents. En effet, de nombreux grands noms de l’informatique quantique, comme IBM, ont tendance à se baser sur une autre métrique : autant de volumequi estime la capacité du système à exécuter des algorithmes généraux. Le communiqué de Google évite toutefois soigneusement de faire référence à cet indicateur.

D’énormes progrès dans la gestion des erreurs

Cela ne veut pas pour autant dire que ces travaux n’ont aucune valeur, car Google revendique tout de même de grands progrès sur un point très important : la correction des erreurs.

En raison de leur dépendance aux états de superposition et d’intrication, les qbits sont des objets très délicats. La moindre variation de l’environnement peut introduire des erreurs qui devront être corrigées ultérieurement. Cependant, préserver l’intégrité du système devient de plus en plus difficile lorsque la puissance du système augmente ; plus le nombre de qbits est élevé, plus il est difficile d’éviter les erreurs.

Mais Google semble avoir réussi à contourner cet obstacle ; l’entreprise affirme en effet que la robustesse de son architecture Willow augmente de façon exponentielle au lieu de diminuer lors de l’introduction de nouveaux qbits !

“Nous avons testé des tableaux de qubits physiques de plus en plus grands, passant d’une grille de qubits 3×3 à une grille de 5×5, puis 7×7. À chaque fois, grâce à nos progrès en matière de correction d’erreurs quantiques, nous avons pu réduire le taux d’erreur de moitié. En d’autres termes, nous avons obtenu une réduction exponentielle du taux d’erreur. Cette prouesse historique est connue dans le domaine sous le nom de « subseuil » : elle réduit les erreurs tout en augmentant le nombre de qubits.», peut-on lire dans le communiqué.

Cerise sur le gâteau, ce système de correction est capable de fonctionner en - réel – un point très important pour l’intégrité des données de sortie, et donc pour envisager d’éventuelles applications pratiques.

Il sera très intéressant de voir si Google décide un jour de sortir de sa zone de confort de RCS, afin de montrer ce que Willow nous réserve lorsqu’il s’agit de résoudre des problèmes plus banals. et arriver au fameux «suprématie quantique» ce que l’entreprise avait déjà affirmé – à tort – en 2019.

???? Pour ne manquer aucune actualité du Journal du Geek, abonnez-vous sur Google News. Et si vous nous aimez, nous avons une newsletter tous les matins.