20.06.2024

Franziska Bechtold

L’essor rapide de Nvidia soulève la question de savoir pourquoi le boom de l’IA aide particulièrement le fabricant de GPU. On vous explique ce qu’il y a derrière.

Nvidia a soudainement dépassé les grandes entreprises technologiques Microsoft, Google et Apple. C’est aujourd’hui l’entreprise la plus valorisée au monde.

En janvier, la part de l’entreprise était encore 45,05 euros Depuis lors, il a fortement augmenté pour atteindre la valeur maximale actuelle de 129,66 eurosLes experts estiment que la raison principale est le battage médiatique qui entoure Intelligence artificielleMais pourquoi les GPU sont-ils cruciaux pour cela ?

De nombreuses personnes associent les cartes graphiques à des jeux informatiques complexes. Mais les apparences sont trompeuses, car Puces graphiques (GPU) peut faire bien plus. « Les GPU existent depuis plus de 15 ans non seulement utilisé pour les jeux. Même à l’époque, les gens reconnaissaient la puissance de calcul qu’ils offraient », explique Ernst HaunschmidChef du département de calcul haute performance à la TU Wien, la futurezone.

➤ Lire la suite : Comment Nvidia est devenue l’entreprise la plus valorisée au monde

Le parallélisme est requis

Les GPU doivent être capables d’afficher plusieurs pixels individuels sur un écran en même temps. Plus l’affichage des jeux s’améliorait, plus la puissance de calcul des GPU devait augmenter, explique Haunschmid.

Ce parallélisme est désormais incontournable dans de nombreux domaines. «Il est également utilisé dans presque tous les domaines de recherche dans lesquels la simulation est réalisée.» Pendant une courte période, l’extraction de crypto-monnaies avec des cartes graphiques était une grande mode, maintenant c’est l’IA.

Réseaux de neurones artificiels sont une partie importante de l’IA. Ils fonctionnent comme des connexions dans le cerveau. D’un côté il y a un Point de départ (le modèle d’entrée) et de l’autre côté vient un Modèle de sortie Ceci est relié par de nombreux neurones artificiels.

Dans la phase de formation d’un modèle d’IA, les connexions entre les neurones individuels ajusté en continude nouveaux chemins sont créés et repondérés jusqu’à ce qu’une entrée produise la sortie souhaitée. En reconnaissance d’images par exemple, l’image d’une pomme doit conduire au mot « pomme » et non au mot « banane ». Si une entrée produit un résultat incorrect, le chemin doit être ajusté jusqu’à ce qu’il mène au résultat correct.

CPU contre GPU

Les GPU sont particulièrement bien adaptés à cela, car ils peuvent traiter tous ces processus simultanément. Maintenant, vous pouvez à juste titre vous demander pourquoi vous utiliseriez une puce graphique s’il n’y a rien à afficher graphiquement. Au lieu de cela, le cerveau d’un ordinateur pourrait également faire le travail CPU (unité centrale de traitement)peut être utilisé à cet effet. Cependant, contrairement au GPU, il traite les tâches successivement. « Les processeurs sont si Généralistes. Ils peuvent calculer, déplacer des données et effectuer des opérations d’E/S sur des périphériques de stockage de données », explique Haunschmid.

➤ Lire la suite : Nvidia présente « la puce la plus puissante du monde »

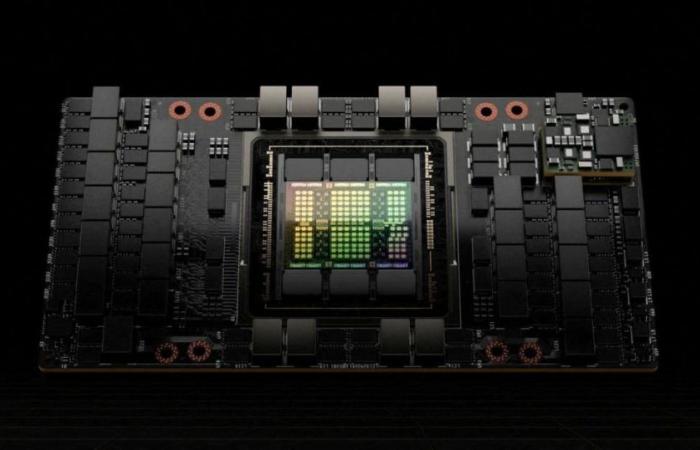

Les CPU et les GPU ont Nucléairequi répartit les tâches et les accomplit ainsi plus rapidement. Ceci est crucial pour que l’ordinateur fonctionne avec précision. Les processeurs sont actuellement disponibles avec jusqu’à 128 Le noyau. Le GPU industriel phare de Nvidia, le H100, a 14 592 noyauxqui accomplissent des tâches spécifiques très rapidement.

Une expérience réalisée par Mythbusters démontre très clairement la différence entre CPU et GPU :

30 000 euros pour une puce graphique

Mais pourquoi Nvidia a-t-il réussi à progresser pour devenir clairement le leader du marché avec une si grande marge ? L’une des raisons est sans aucun doute la haute qualité technique de ses produits. Mais sa politique tarifaire joue également un rôle important.

Votre meilleure carte graphique de jeu actuellement, la GeForce RTX4090coûte actuellement 1.779 euros et pourrait avec 16 384 Le noyau du moins à première vue, il pourrait également être candidat pour des applications en IA. Cependant, Nvidia a déjà exclu dans ses conditions d’utilisation l’utilisation de cartes grand public de la série GeForce dans les centres de données il y a des années.

Ceci est également confirmé par Haunschmid, qui explique que Nvidia dispose d’un frein technique ce qui empêche l’utilisation des cartes de jeu à des fins industrielles. Une pratique similaire a déjà été utilisée dans le minage de Bitcoin. La raison en est on ne peut plus évidente : « Il y a une différence de prix significative par rapport aux cartes professionnelles. » Le H100 les coûts entre 30 000 et 40 000 euros.

Des centaines de milliers de GPU pour Meta et Microsoft

Les grandes entreprises n’ont pas besoin d’un, mais de centaines de milliers de GPU. Selon les estimations des analystes d’Omdia Research (via Statista), Nvidia aura 150.000 H100-GPU et Microsoft et Méta livré. 50 000 jetons est allé à Tencent, Oracle, Amazon et Google.

➤ Lire la suite : Nvidia : la crypto n’a aucun bénéfice pour la société

Les GPU professionnels sont spécifiquement optimisés pour une utilisation industrielle grâce à des logiciels et du matériel spécifiques. Avec CUDA Nvidia a le sien interface ce qui accélère encore les processus sur ses GPU.

Un niveau élevé est également crucial Bande mémoirece qui permet au GPU professionnel d’accéder à beaucoup de données en même temps. Ceci est essentiel pour les applications d’IA où les entrées doivent être comparées aux entrées de la base de données afin de fournir rapidement le résultat souhaité.

« La domination va se poursuivre cette année »

Grâce à des années de travail sur ce système complet – composé d’un GPU, d’interfaces et de logiciels – Nvidia a réussi à offrir une base technique sans précédent pour l’utilisation de l’IA. Selon Haunschmid, le logiciel est la principale raison du succès de Nvidia : « Il sera difficile de convaincre d’autres entreprises. La domination de Nvidia se poursuivra cette année. Cette domination du marché est évidente dans le H100 : quiconque souhaite acheter le GPU doit désormais s’attendre à des temps d’attente de plus d’un an calculer.

AMD veut rattraper son retard

Mais le secteur d’activité reste intéressant pour d’autres entreprises à condition qu’elles parviennent à rattraper leur retard technique. Les plus grands concurrents DMLA et Intel a échoué jusqu’à présent.

AMD attaque actuellement Prix de dumping pour sa puissance KI-GPU MI300X Cela coûte entre 15 000 et 20 000 euros. Mais même s’il est censé surpasser le H100, le système Nvidia est plus stable, fiable et largement utilisé. Mais ce n’est probablement qu’une question de temps avant qu’AMD puisse au moins ralentir la montée en puissance de Nvidia.

Il serait également intéressant que l’utilisation de l’IA devienne plus répandue. Parce que la phase de formation, qui nécessite actuellement le plus de puissance, nécessite des processeurs différents de ceux que l’on appelle Phase d’interférence.

En cela, le modèle déjà entraîné est alimenté avec de nouvelles données afin de résoudre une tâche. « Ici, les modèles linguistiques doivent trouver exactement la bonne pièce dans un immense magasin de données », explique Haunschmid. Outre les grandes entreprises, les start-up travaillent également dur pour développer des processeurs d’IA spéciaux spécialement conçus à cet effet.