Nous nous tournons de plus en plus vers l’IA pour trouver des réponses à nos problèmes et trouver des informations. Mais que se passerait-il si l’IA nous induisait en erreur, le saurions-nous ?

En seulement quelques mois d’existence, ChatGPT a atteint les 100 millions d’utilisateurs. Un chiffre énorme qui a pris près de quatre ans d’existence à Facebook et à d’autres outils technologiques. Cela prouve la confiance que de plus en plus d’utilisateurs accordent à ces outils d’IAdont Gemini et Claude. Mais contrairement aux moteurs de recherche traditionnels qui se contentent de retracer les sources, les outils d’IA n’affichent pas les différentes sources. Ils partagent simplement les informations qu’ils trouvent exactes. Mais dans ce cas, L’IA peut-elle nous induire en erreur ? ? Si oui, comment le saurions-nous ?

L’IA a été entraînée pour donner la réponse la plus précise, mais…

Contrairement aux moteurs de recherche qui agissent comme des agents dans les bibliothèques pour trouver tous les sites qui apportent une réponse à ce que l’on recherche, Les IA fonctionnent comme des experts qui répondent directement à nos questions. Pour arriver à ce stade, ils ont été entraînés sur d’énormes volumes de données qui définissent leur précision et leur savoir-faire. Tout comme un humain est voué à devenir un mauvais professionnel, s’il a reçu un enseignement de mauvaise qualité, les réponses d’une IA seraient de mauvaise qualité si les données utilisées pour sa formation sont pauvres et insuffisantes.

À leurs débuts, alors qu’ils ont été formés sur d’énormes quantités de données, des centaines de milliards, les outils d’IA sont frappés par une maladie courante : l’hallucination. Même si les modèles avaient la réponse précise, ils pouvaient à tout moment se lancer dans un discours logorrhéique. avec des informations « inventées » à partir de zéroapparemment cohérent, mais faux en réalité. Une nouvelle requête permettait parfois d’accéder à la réponse souhaitée.

Les hallucinations sont l’œuvre de données biaisées ou incomplètes qui ont été utilisés pour former ces modèles ; elles sont aussi la conséquence de la complexité du langage humain, mais aussi le résultat d’une requête mal formulée. Et comme le précise l’avertissement au bas de chaque LLM, les réponses données par ces outils ne peuvent pas être considérées comme un évangilemais doit toujours être sujet à vérification.

À lire aussi : L’intelligence artificielle pourrait-elle surpasser l’intelligence humaine ?

L’IA peut être trompeuse : cela dépend des données et de leurs paramètres

Comme nous l’avons vu précédemment, les données utilisées pour leur formation constituent la force des outils d’IA. S’ils n’ont pas été formés dans un domaine disposant de données variées et complètes, il est probable que leur intervention dans ce domaine frise le désastre. Mais vous ne le sauriez probablement pas. Ainsi la nécessité d’avoir un minimum de prérequis avant d’accorder une confiance totale aux réponses de l’IA.

Si vous demandez à ChatGPT ou Gemini à propos de domaines qu’ils ne maîtrisent pasil est probable qu’ils vous répondront humblement comme n’ayant aucune information à ce sujet. Il peut toutefois arriver qu’ils s’engagent dans une démonstration folle. Cela se produit le plus souvent lorsqu’ils disposent d’informations, mais d’informations insuffisantes.

De plus, les IA sont généralement formé sur des données historiques. Ils ne sont pas pas mis à jour en temps réel pour rester au courant de l’actualité. Dans ce cas, si la question porte sur un sujet d’actualité, la réponse donnée pourrait être incorrecte.

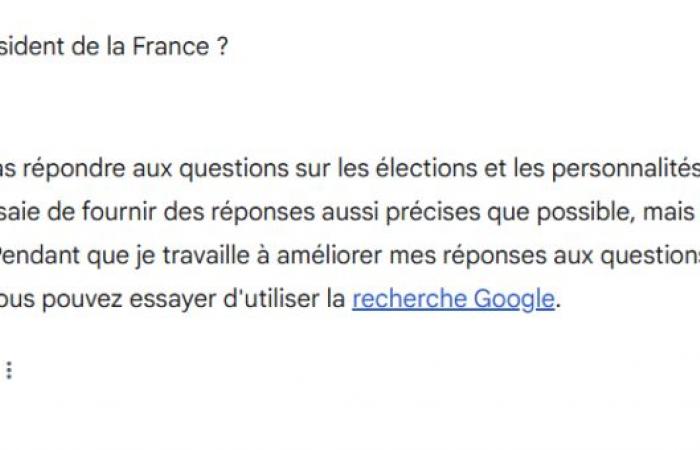

De plus, les données ne font pas tout : les paramètres sont également importants. Gardons à l’esprit que les IA ne sont que des outils qui obéir aux directives que leur donne leur créateur. C’est notamment la raison pour laquelle ChatGPT plante lorsqu’on lui pose des questions relatives à certaines personnes. Il en est de même pour Gémeaux qui refuse systématiquement de répondre aux questions liées à la politique, même les plus triviales comme : “Qui est le président de la France?”.

Là encore, l’utilisateur n’est pas informé des paramètres sous-jacents sur lesquels opère un outil d’IA. Il est donc possible qu’un outil soit programmé pour mentir sur certains sujets. Cela ne serait pas nouveau, puisque les moteurs de recherche peuvent être manipulés pour cacher certaines informations. Les entreprises, bien souvent, trouvent des moyens de justifier leur démarche, alors même qu’elle constitue un garrot pour l’élargissement des connaissances et le droit d’accès à l’information.

BuzzWebzine est un média indépendant. Soutenez-nous en nous ajoutant à vos favoris sur Google Actualités :